В основе нашего мира лежат три составляющие: вещество, энергия и информация. Как много в мире вещества, энергии и информации? Можно ли их измерить и как именно? Нам известны способы измерения количества вещества и энергии. Но как быть с информацией? Можно ли ее измерить?

Ранее уже отмечалось, что существует несколько подходов к оценке количества информации. Сейчас мы более подробно остановимся на одном из них.

Любое сообщение будет являться информативным, если оно пополняет знания человека, т.е. уменьшает неопределенность его знаний.

Равновероятные события

Например, при подбрасывании монеты мы пытаемся угадать, какой стороной она упадет. Возможен один из вариантов исхода: монета окажется в положении «орел» или «решка». Каждое из этих двух событий окажется равновероятным, т. е. ни одно из них не имеет преимущества перед другим. Перед подбрасыванием монеты никто не может знать, как она упадет, т.е. существует неопределенность знания. После же наступления события, наоборот, присутствует полная определенность, так как бросающий получает зрительное сообщение о положении монеты, которое, в свою очередь, уменьшает неопределенность его знания в два раза, поскольку из двух равновероятных событий произошло одно.

Другим примером является ситуация с шестигранным кубиком, т.е. перед броском никто не может знать, какой стороной он упадет. В данном случае присутствует возможность получить один результат из шести равновероятных. Таким образом, до броска неопределенность знаний бросающего будет равна 6, после же броска, она уменьшится ровно в 6 раз, поскольку именно 6 равновероятных событий может произойти.

Рассмотрим пример, где для экзамена приготовили 40 билетов. Вероятность событий, которые произойдут при вытягивании билета, будет равна 40. Причем эти события будут равновероятны. При этом неопределенность знаний студента перед выбором билета, будет равна 40. Соответственно неопределенность знания после того как студент взял билет уменьшится в 40 раз. Зададимся вопросом, зависит ли этот показатель от номера вытянутого билета. Нет, поскольку события равновероятны.

Проанализировав все рассмотренные выше примеры, можно прийти к выводу, что чем больше исходное число возможных равновероятных событий, тем в большее количество раз уменьшается неопределенность знаний, и тем большее количество информации будет содержаться в сообщении о результатах опыта.

Неравновероятные события

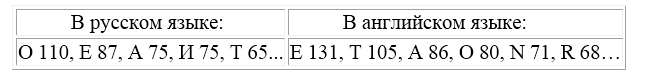

Рассмотрим в качестве примера разговорные языки. Обратимся к фактам доказанных исследований, которые показывают, что во всех разговорных языках одни буквы встречаются гораздо чаще, чем другие. Результаты исследований подтверждают, что на $1000$ букв в разных разговорных языках приходится различное число повторений. В качестве примеров в таблице приведены некоторые буквы в русском и английском языках:

Рисунок 1.

Помимо этого, вероятность появления отдельных букв будет зависеть от того, какие буквы используются перед ними. Так, в русском языке после гласной никогда не может стоять мягкий знак, а также в словах не используются четыре гласные подряд и т.д. Разговорные языки имеют, как правило, свои особенности и закономерности. Именно поэтому количество информации, содержащееся в сообщениях любого разговорного языка, неприемлемо оценивать с помощью формулы Хартли, которая используется в алфавитном подходе к оценке информации и характерна для примеров с равновероятными событиями (примеры с монетой и кубиком).

Как определить, какое количество информации содержит, например, текст романа "Война и мир", или фрески и полотна великих итальянских художников, или генетический код человека? Ответы на эти вопросы и подобные им науке пока не известны и, по всей вероятности, еще не скоро будут известны. Однако всех интересует, возможно ли объективно оценить количество информации? К задаче подобного рода можно отнести следующий пример.

Как выяснить, являются ли равновероятными сообщения "первой выйдет из здания женщина" и "первым выйдет из здания мужчина"? Однозначного ответа на этот вопрос нет. Все будет зависеть от того, о каком именно здании идет речь. Если это, например, здание гинекологической клиники, то вероятность выйти первой у женщины очень высока, если это военная казарма, то вероятность выйти первым для мужчины будет выше, чем для женщины, а вот если это здание кинотеатра, то вероятности выйти первыми для мужчины и женщины будут одинаковыми.

Оценка количества информации. Формула Шеннона

Для решения задач подобного рода используется общая оценка количества информации, предложенная американским учёным Клодом Шенноном в 1948г. Созданная им формула определения количества информации способна учитывать возможную неодинаковую вероятность сообщений, содержащихся в наборе. Шеннон при создании формулы использовал применяемую в математике и гидродинамике вероятностную меру неопределенности (называемую энтропией) для того, чтобы в полной мере оценить состояние изучаемой системы и получить максимально возможную информацию о протекающих в этой системе процессах. Эта оценка количества информации, по существу, является вероятностной мерой, и, как оценка неопределенности, она отражает способность какого-либо источника проявлять все новые и новые состояния и таким образом отдавать информацию.

Шеннон определил энтропию как среднюю логарифмическую функцию множества вероятностей возможных состояний системы (возможных исходов опыта). Для расчета энтропии Шеннон предложил следующее уравнение:

$H= -( p_1log_2p_1+p_2log_2p_2+. . .+p_Nlog_2p_N)$,

где $p_i$ - вероятность появления $i$-того события в наборе из $N$ событий.

Тогда количество информации, полученное в результате опыта, будет не что иное, как разность между энтропией системы до ($H_0$) и после ($H_1$) опыта:

$I=H_0-H_1$,

причем если неопределенность в результате опыта полностью исключается, то имеем:

$I= -H_1$

$I=\Sigma (p_ilog_2p_i), i=1,\dots ,N$.

Рассмотрим пример, подтверждающий использование данной теории Шеннона на практике.

В озере обитают пескари и окуни. Подсчитано количество особей в каждой популяции (пескарей - $1500$, а окуней - $500$). Необходимо определить, сколько информации содержится в сообщениях о том, что рыбак выловил пескаря, окуня, вообще рыбу?

Решение. События улова пескаря или окуня не являются равновероятными, поскольку окуней в озере обитает намного меньше, чем пескарей.

Общее количество пескарей и окуней, обитающих в озере:

$1500 + 500 = 2000$.

Определим вероятность улова пескаря:

$p_1= \frac{1500}{2000} = 0,75$,

Определим вероятность улова окуня:

$p_2 - \frac{500}{2000} = 0,25$.

$I_1=log_2(\frac{1}{p_1}), I_1=log_2(\frac{1}{p_2})$,

где $I_1$ и $I_2$ - вероятности улова пескаря и окуня соответственно.

Количество информации, содержащейся в сообщении об улове пескаря:

$I_1 = log_2(\frac{1}{0,75}) » 0,43$ бит,

Количество информации, содержащейся в сообщении об улове окуня:

$I_2=log_2(\frac{1}{0,25}) » 2$ бит.

Количество информации, содержащейся в сообщении об улове рыбы (карася или окуня) рассчитывается по формуле Шеннона:

$I = - p_1log_2p_1 - p_2log_2p_2$

$I = -0,75 \cdot log_20,75- 0,25 \cdot log_20,25=-0,75 \cdot (\frac{log0,75}{log2})-0,25 \cdot(\frac{log0,25}{log2}) =0,604 бит » 0.6$ бит.

Ответ: в сообщении содержится $0,6$ бит информации